本次周报主要整理了图片视频超分和去噪的常用数据集和SHVC中去噪的试验情况,周五讨论到的运动模糊数据集制作是使用高帧率的视频通过算法合成的运动模糊图像。

1.数据集整理

本部分针对常用超分和去噪的数据集进行了整理,超分数据集又分为图片超分数据集和视频超分数据集。

超分最常用的训练集为NTIRE2017年发布的DIV2K[2]和NTIRE2019最新发布的REDS[3]数据集,以及Vimeo-90K[9]。由于超分数据集容易制作,所以也有很多文章采用自己制作的数据集进行训练。为了统一进行效果对比,了解常用的测试集很有必要。图片超分中,常用的数据集有Set5[4], Set14[1],B100[5],Urban100[6],Manga109[7]。视频超分中,最常用的是Vid4[8]测试集。

去噪数据集中最常用的是REDS[3]和DBNSet[10]。他们的运动模糊均是通过高帧率的相邻帧使用算法合成得到。

1.1常用数据集介绍

对目前最常用的超分数据集进行介绍

#####1.1.1 DIV2K

DIV2K ( DIVerse 2K ) 是NTIRE在2017年发布的高清(2k分辨率)图片修复的数据集,其中包含800张训练图片,100张验证图片,100张测试图片,常用于图片的超分和去噪。

项目地址:https://data.vision.ee.ethz.ch/cvl/DIV2K/

1.1.2 REDS

REDS (REalistic and Diverse Scenes dataset) 是NTIRE在2019年发布的高质量(720p)视频超分和去模糊数据集。它包含来240个训练序列,30个验证序列,30个测试序列,总共270000张图片。通过四种视频质量降级方法得到四个子数据集如下:

- Bicubic 下采样

- 带运动模糊的Bicubic 下采用

- 运动模糊

- 带压缩的运动模糊

其中运动模糊是通过多帧连续图像用算法合成的运动模糊图像,使用不同帧数合成不同程度的运动模糊。

项目地址:http://www.vision.ee.ethz.ch/ntire19/

下载地址:

- https://competitions.codalab.org/competitions/21482#participate-get-data

- https://competitions.codalab.org/competitions/21483#participate-get-data

- https://competitions.codalab.org/competitions/21475#participate-get-data

- https://competitions.codalab.org/competitions/21476#participate-get-data

1.1.3 Vimeo90K

Vimeo90K是一个大规模高质量的视频数据集,包含了从vimeo.com下载的89800个视频片段,每个片段包含7帧,每帧size为448x256x3。涵盖了大量不同的场景和动作,转为 视频去噪,视频去块,视频超分,视频插帧 任务设计。

项目地址:http://toflow.csail.mit.edu/

下载地址:https://github.com/anchen1011/toflow

1.1.4 Vid4

Vid4是视频超分领域广泛使用的测试集,视频超分文章中效果展示的图片均来自于此。其中包含 日历,城市,树叶,行人四组视频片段。

| GT spatial size | (720 x 576 x 3), (704 x 576 x 3), (720 x 480 x 3), (720 x 480 x 3) |

|---|---|

| frame of each clip | 41, 34, 49, 47 |

| testing samples | 171 |

下载地址:https://drive.google.com/drive/folders/10-gUO6zBeOpWEamrWKCtSkkUFukB9W5m

1.1.5 DBNSet

DBNSet是通过手持摄像头捕获得到的数据集,主要用于去运动模糊。其模糊帧通过平均多张高速率(240fps)的帧得到。其中图片大小为1280x720x3,共包含71个视频片段,其中训练片段61个,测试片段10个,总共6708帧图像。

项目地址:http://www.cs.ubc.ca/labs/imager/tr/2017/DeepVideoDeblurring/

下载链接:http://www.cs.ubc.ca/labs/imager/tr/2017/DeepVideoDeblurring/#dataset

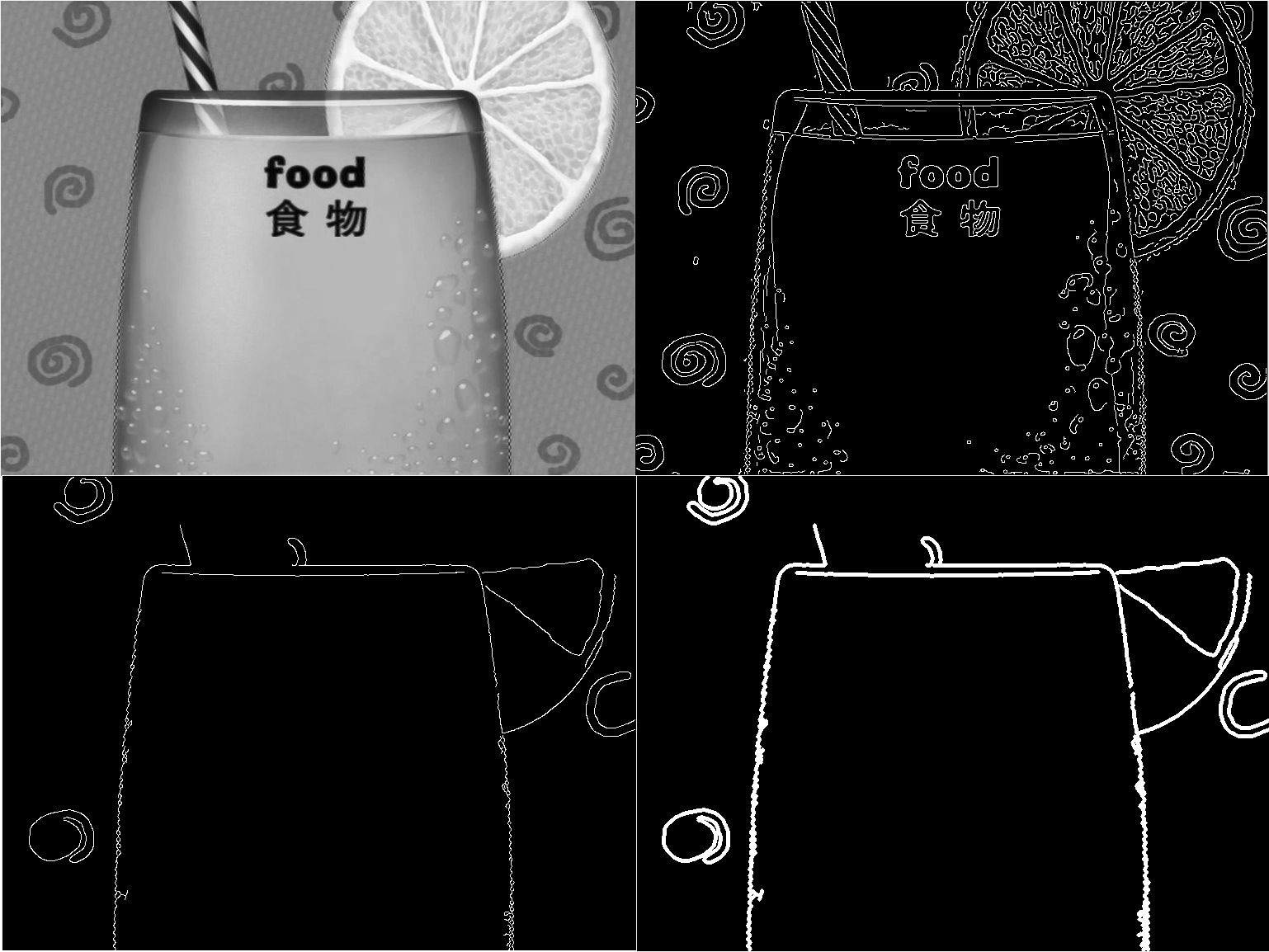

1.1.6 其它测试集

开始提到的Set5[4], Set14[1],B100[5],Urban100[6],Manga109[7]等常用于图片超分的测试。图片超分中展示的效果图均选自这些测试集。

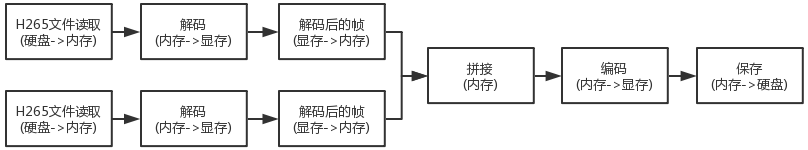

2 SHVC

之前通过简单的10层卷积加全局残差实现了一个简单的去噪网络,在此基础上将原来的10层卷积替换成了16层残差块重新训练更大的网络进行去噪。训练集使用原来blind的数据集,即QP19-QP37,size为42x42的图片(训练集和测试集均为42x42)。

原来的简单网络,训练集和测试集的提升在均在0.6db左右,BasketballDrive码流测试结果提升0.1–0.2db(具体值看下表),换用16层残差替换之后的网络训练集和测试集的提升均在0.8db左右,但BasketballDrive码流测试结果反而下降。

上面结果显示,训练集和测试集提升异常地高,而码流测试结果退化严重。针对以上结果,我和宋师兄讨论之后分析原因有以下两点

- 训练图片size太小,仅有42x42,所以训练集和测试集感受野为整张图大小,而实际测试大图时则不同。

- 训练集特殊的制作方式 (先裁剪后编码) 不适合去噪任务,实际使用时为先编码后分割进行测试。

最后采用之前的简单网络(测试码流有0.1–0.2db的提升)进行了码流测试,测试结果如下:

结果显示,在去噪效果不好的情况下,码流下降情况依然可观,接下来便可以重新制作数据集进行SNR相关的工作。

参考资料

- Zeyde, R., Elad, M., Protter, M.: On single image scale-up using sparse-

representations. In: Curves and Surfaces, pp. 711{730. Springer (2012) - R. Timofte, E. Agustsson, L. Van Gool, M.-H. Yang,

L. Zhang, et al. Ntire 2017 challenge on single image superresolution:

Methods and results. In CVPR 2017 Workshops. - Seungjun Nah, Sungyong Baik, Seokil Hong, Gyeongsik

Moon, Sanghyun Son, Radu Timofte, and Kyoung Mu

Lee. Ntire 2019 challenges on video deblurring and superresolution:

Dataset and study. In CVPRW, June 2019. - Bevilacqua, M., Roumy, A., Guillemot, C., Alberi-Morel, M.L.: Low-complexity

single-image super-resolution based on nonnegative neighbor embedding. In:

BMVC. (2012) - Martin, D., Fowlkes, C., Tal, D., Malik, J.: A database of human segmented natural

images and its application to evaluating segmentation algorithms and measuring

ecological statistics. In: ICCV. (2001) - Huang, J.B., Singh, A., Ahuja, N.: Single image super-resolution from transformed

self-exemplars. In: CVPR. (2015) - Matsui, Y., Ito, K., Aramaki, Y., Fujimoto, A., Ogawa, T., Yamasaki, T., Aizawa,

K.: Sketch-based manga retrieval using manga109 dataset. Multimedia Tools and

Applications (2017) - C. Liu and D. Sun. A bayesian approach to adaptive video

super resolution. In CVPR, 2011. - Tianfan Xue, Baian Chen, Jiajun Wu, Donglai Wei, and

William T Freeman. Video enhancement with task-oriented

flow. arXiv preprint arXiv:1711.09078, 2017. - Su, Shuochen, et al. “Deep video deblurring for hand-held cameras.” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2017.

- https://xinntao.github.io/open-videorestoration/rst_src/datasets_deblur.html